Token & Transformer: il cuore dei moderni modelli di Machine Learning

Come una tecnologia unificata ha accelerato l’evoluzione dell’AI

Pubblicato da Luigi Bidoia. .

Strumenti Machine learning e EconometriaLa varietà degli input e la frammentazione storica dell’IA

Per decenni l’elaborazione automatica — o “intelligente” — delle informazioni si è sviluppata seguendo percorsi distinti, quasi isolati gli uni dagli altri. A seconda del tipo di dato da analizzare o del problema da risolvere, sono emerse aree di studio separate:

- Linguaggio umano: interpretazione di testi e dialogo;

- Visione: riconoscimento di oggetti e categorie a partire da immagini;

- Audio: distinzione di suoni, parlato e musica;

- Serie storiche: previsione di valori nel tempo;

- Decisioni e controllo: giochi (dama, scacchi, Go), agenti e apprendimento per rinforzo.

Ogni tipologia di input o problema inaugurava la propria area di ricerca, con approcci, strumenti e modelli fortemente specializzati. Questa frammentazione, naturale nelle prime fasi dell’IA, aveva però un limite evidente: impediva di sfruttare sinergie, rallentava il trasferimento di idee tra campi diversi e complicava l’integrazione di più forme di informazione.

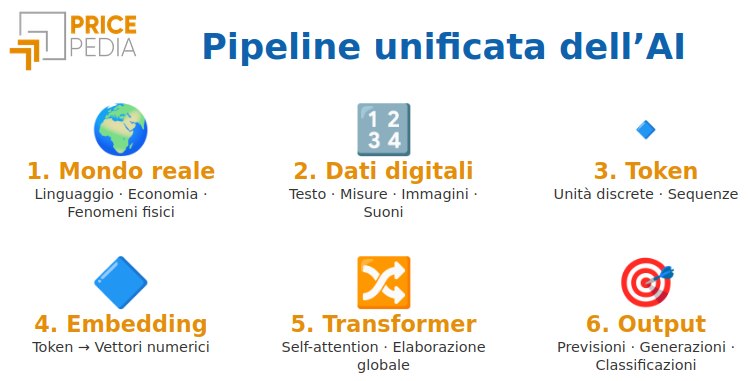

La svolta è arrivata quando si è compreso che esisteva un modo per rappresentare qualsiasi tipo di input — testo, immagine, audio, dati temporali — in una forma comune, permettendo finalmente a un’unica architettura di trattarli allo stesso modo. Il cuore di questa rivoluzione è il token[1].

Il token come unità tecnica di rappresentazione

Per poter trattare in modo uniforme dati molto diversi — testi, immagini, audio, serie storiche — l’intelligenza artificiale moderna utilizza un principio molto semplice: invece di affrontare l’intero insieme di dati nella sua complessità originaria, lo scompone prima in sequenze e poi in unità elementari di senso. Queste unità sono chiamate token.

Il token è una parte discreta del dato:

- una parola o un frammento di parola nel testo,

- un piccolo patch in un’immagine,

- una finestra temporale nell’audio,

- una singola misurazione di un fatto economico.

Indipendentemente dal tipo di informazione di partenza, ogni input può essere spezzato in questi elementi minimi, per poi disporli in un ordine preciso, formando una sequenza. L’ordine è fondamentale: cambia il significato di una frase, la struttura di un’immagine e l’andamento di un fenomeno nel tempo.

Per poter essere processato, ciascun token è poi trasformato in un vettore di numeri attraverso un’operazione detta embedding, ottenendo un token embedded. È questa rappresentazione vettoriale dei token, ordinata nella sequenza, l’unità effettiva su cui i modelli moderni calcolano relazioni, dipendenze e pattern statistici. Questa trasformazione — da dato grezzo a sequenza di token embedded — è ciò che rende possibile utilizzare un’unica architettura di modello, come il Transformer, per trattare informazioni di natura molto diversa.

Vuoi restare aggiornato sull’andamento dei mercati delle commodity?

Iscriviti gratuitamente alla newsletter PricePedia!

Il Transformer: elaborazione globale della sequenza

Una volta trasformato un dato complesso in una sequenza di token embedded — cioè in una lista ordinata di vettori numerici — entra in gioco l’architettura che ha rivoluzionato l’intelligenza artificiale moderna: il Transformer.

La sua caratteristica fondamentale è la capacità di non elaborare i token uno alla volta, come avveniva nelle architetture precedenti, ma di analizzare l’intera sequenza in modo globale e simultaneo.

Per ogni elemento della sequenza, il modello valuta quali altri token contengano informazioni rilevanti e con quale peso debbano essere considerati.

Questo processo prende il nome di self-attention: un meccanismo che permette a ogni token embedded di “guardare” tutti gli altri, misurando dinamicamente la loro importanza reciproca.

In questo modo il Transformer coglie relazioni locali e non locali, anche tra elementi molto distanti nella sequenza.

Dal punto di vista computazionale, i Transformer sono progettati per parallelizzare i calcoli su tutti i token, sfruttando in modo efficiente le moderne architetture hardware (GPU, TPU).

Questa caratteristica li rende particolarmente potenti e scalabili rispetto alle reti neurali tradizionali.

Il processo di apprendimento

Abbiamo già detto che una delle funzioni essenziali di un Transformer è quella di apprendere le relazioni interne a una sequenza, cioè il modo in cui i diversi token embedded interagiscono tra loro. In altre parole, il modello impara quali strutture, schemi o configurazioni compaiono ripetutamente all’interno della sequenza.

Ma il Transformer va oltre: non si limita a individuare pattern interni a una singola sequenza, bensì apprende anche le

regolarità che compaiono tra molte sequenze diverse.

Attraverso l’osservazione di migliaia o milioni di esempi, il modello costruisce una mappa statistica di ciò che tende a ripetersi,

di ciò che segue qualcos’altro e di come certe forme nei dati evolvono in altre.

Grazie a questa conoscenza, un Transformer è in grado di prevedere i token successivi,

generare nuove sequenze coerenti con quelle osservate o classificare una sequenza

in base ai pattern che contiene.

Nel caso di token ottenuti da misure temporali, questo apprendimento riguarda sia i pattern locali (pendenza, oscillazioni, inversioni di tendenza, picchi) sia le dipendenze a lungo termine (trend, stagionalità, ciclicità, ritmi ricorrenti). Se le misure coinvolgono più variabili, il modello apprende anche le relazioni tra variabili: se la variazione di una anticipa quella di un’altra, con quanto ritardo, in quale direzione e con quale intensità.

In sintesi

La scomposizione dei dati in token elementari, la loro trasformazione in vettori numerici dotati di significato

(gli embedded token), la loro organizzazione in sequenze ordinate e lo sviluppo di un’architettura neurale –

il Transformer – capace di elaborare tali sequenze in modo estremamente efficiente, hanno contribuito

ad avvicinare tra loro aree dell’intelligenza artificiale che in passato procedevano separatamente.

Grazie a questa rappresentazione unificata, i progressi ottenuti in un settore sono diventati rapidamente

utili anche negli altri.

I grandi successi raggiunti nel decennio scorso nell’elaborazione del linguaggio hanno infatti aperto la strada

a sviluppi altrettanto significativi nel riconoscimento delle immagini e, più recentemente, nella previsione delle

serie temporali. Come discusso nell’articolo

L'arrivo dei modelli fondazionali nelle previsioni di serie,

ai large model originariamente basati sul linguaggio si sono affiancati modelli di dimensioni comparabili nel

campo della visione artificiale e, oggi, anche nella modellazione e previsione di dati numerici.

Nota

- Nota storica sul concetto di “token”. Il termine nasce nella linguistica computazionale già negli anni ’60, per indicare l’unità elementare in cui viene suddiviso un testo. Negli anni 2010, con i modelli distribuzionali (es. Word2Vec, GloVe), i token vengono trasformati in vettori numerici continui. Con tecniche come Byte Pair Encoding (BPE) e SentencePiece, il token diventa un’unità flessibile e in gran parte indipendente dalla lingua. Il passaggio decisivo verso l’unificazione multimodale arriva con i Vision Transformer (2020), che trattano porzioni di immagini come token analoghi a quelli del testo. Da allora il token funge da rappresentazione universale capace di descrivere testi, immagini, audio e dati strutturati in modo uniforme.